Yapay zeka, son yılların en hızlı gelişen teknolojilerinden biri olarak hayatımızın birçok alanında yerini aldı. Ancak beraberinde kritik bir soruyu da gündeme getiriyor: ''Yapay zeka hacklenebilir mi?'' işte tam bu noktada yapay zeka güvenliği kavramı öne çıkıyor. Yapay zeka güvenliği, yalnızca teknoloji şirketleri için değil, günlük kullanıcılar ve kurumlar için de büyük önem taşıyor.

Yapay zeka sistemleri, çoğunlukla büyük miktarda veriye dayanarak çalışıyor. Bu veriler, kullanıcı bilgilerini, finansal kayıtları veya kritik kurumsal verileri içerebilir. Dolayısıyla herhangi bir güvenlik açığı, sadece teknik bir sorun değil, aynı zamanda kişisel gizlilik ve veri güvenliği açısından da ciddi bir risk anlamına geliyor. Son dönemde siber güvenlik alanında yaşanan gelişmeler, yapay zekanın her ne kadar güçlü olsa da tamamen dokunulmaz olmadığını gösteriyor.

Yapay Zeka ve Veri Güvenliği Temelleri

Yapay zeka sistemleri, doğru ve verimli çalışabilmek için büyük miktarda veriye ihtiyaç duyar. Bu veriler, genellikle kullanıcıların davranışlarını, tercihlerine dair bilgileri veya daha kritik durumlarda sağlık kayıtları ve finansal işlemleri kapsayabilir. Dolayısıyla yapay zekanın güvenliği, doğrudan veri güvenliği ile bağlantılıdır. Bir yapay zeka modeli, doğru eğitildiğinde kullanıcıya en iyi sonuçları sunar. Ancak eğitim sırasında kullanılan verilerin kötü niyetli kişiler tarafından değiştirilmesi, modelin çıktılarında ciddi hatalara neden olabilir. Buna “veri zehirleme (data poisoning)” saldırısı denir ve yapay zekanın hacklenme ihtimallerinden biri olarak kabul edilir.

Yapay Zekanın Hacklenme Senaryoları Nelerdir?

1. Veri Zehirleme (Data Poisoning)

Saldırganlar eğitim verisine kötü amaçlı örnekler ekleyerek veya mevcut örnekleri değiştirerek modelin hatalı öğrenmesine yol açar. Örneğin bir yüz tanıma modeline belirli görünüşlerde yanlış etiketlenmiş görüntüler karıştırılırsa, model o kişileri yanlış tanımaya başlar.

Savunma: Eğitim veri havuzunu doğrulama, veri kaynaklarını güvence altına alma, anomali tespiti ile olağan dışı örnekleri engelleme, kademeli eğitim (curriculum learning) ve farklı kaynaklardan doğrulama.

2. Adversarial Ataklar (Kasıtlı Girdi Manipülasyonu)

Saldırgan, insan gözüyle fark edilemeyecek küçük değişiklikler yaparak modelin yanlış tahmin vermesini sağlar. Örneğin bir trafik işaretine eklenen ince bir gürültü, o işaretin yanlış sınıflandırılmasına neden olabilir.

Savunma: Girdi ön işleme, adversarial eğitim (modeli saldırılara karşı eğitme), model doğrulama katmanları ve robust (dayanıklı) mimariler.

3. Model Hırsızlığı / Model Stealing

API üzerinden yapılan çok sayıda sorgu ile saldırgan, modelin davranışını taklit eden bir kopya oluşturabilir. Bu, telif hakkı, ekonomik zarar ve daha sonra kötüye kullanım riski doğurur.

Savunma: API oran sınırlamaları (rate limiting), sorgu gözetimi, su işaretleme (watermarking) ve hizmet içi kullanım kısıtları.

4. Model İnversiyonu (Model Inversion / Privacy Leak)

Saldırgan, modelin çıktılarından yola çıkarak eğitim verisindeki hassas bilgileri (ör. kullanıcı verileri, görüntüler) yeniden oluşturabilir. Özellikle kişisel veriler içeren modellerde tehlikelidir.

Savunma: Diferansiyel gizlilik (differential privacy) teknikleri, model çıktılarının sınırlandırılması, eğitim verileri için anonimleştirme ve erişim kontrolü.

5. Backdoor / Trojan Saldırıları

Saldırgan, eğitim sürecine gizli tetikleyici (trigger) yerleştirir; üretim ortamında bu tetikleyici aktif edildiğinde model kasıtlı olarak istenmeyen davranış sergiler. Örneğin belirli bir desenli logo göründüğünde yüz tanımayı atlatma.

Savunma: Eğitim veri zincirinin güvenliği, tedarikçi doğrulama, model inceleme (model auditing) ve tetikleyici tespiti için istatistiksel testler.

6. Tedarik Zinciri ve İç Tehditler

Üçüncü taraf kütüphaneler, önceden eğitilmiş modeller veya veri sağlayıcılar aracılığıyla sisteme kötü yazılım veya arka kapı girme riski bulunur. Ayrıca içerden yetkili kötü niyetli aktörler de veriye erişip sızdırabilir.

Savunma: Tedarikçi güvenliği değerlendirmesi, bağımsız kod ve model denetimleri, en küçük ayrıcalık ilkesi (least privilege), düzenli güvenlik taramaları ve izleme.

Yapay Zeka Güvenliği İçin Alınabilecek Önlemler

Veri Güvenliği ve Doğrulama

Yapay zeka sistemlerinin en kritik zayıflığı kullanılan veridir. Eğitim setlerine yanlış veya kötü amaçlı veriler sızdırıldığında modelin performansı düşer. Bunun önüne geçmek için:

- Veri kaynaklarını güvenilir sağlayıcılardan seçmek,

- Anomali tespiti ile olağan dışı verileri ayıklamak,

- Verileri anonimleştirerek kişisel bilgilerin sızmasını engellemek önemlidir.

Diferansiyel Gizlilik (Differential Privacy)

Eğitim sürecinde bireysel kullanıcıların verilerinin geri çıkarılamaması için diferansiyel gizlilik teknikleri kullanılabilir. Bu yöntem, istatistiksel gürültü ekleyerek verilerin bütünlüğünü korurken, kişisel gizliliği güvence altına alır.

Model Dayanıklılığını Artırma

Yapay zeka güvenliği, sadece veriyle sınırlı değildir. Modelin saldırılara karşı daha dayanıklı hale getirilmesi gerekir. Bunun için:

- Adversarial eğitim (saldırılara karşı modelin özel olarak eğitilmesi),

- Robust (dayanıklı) mimari seçimleri,

- Düzenli stres testleri yapılabilir.

Erişim Kontrolü ve API Güvenliği

Yapay zeka tabanlı uygulamaların büyük kısmı API üzerinden hizmet verir. API kötüye kullanımına karşı:

- Güçlü kimlik doğrulama,

- Kısa süreli erişim anahtarları,

- Rate limiting (sorgu sınırlandırma) ve

- Anormal sorgular için gerçek zamanlı izleme uygulanmalıdır.

Tedarik Zinciri Güvenliği

Önceden eğitilmiş modellerin veya üçüncü taraf kütüphanelerin içine gizlenmiş kötü yazılımlar ciddi tehdit oluşturabilir. Bu nedenle:

- Açık kaynak kütüphaneler taranmalı,

- Tedarikçiler güvenlik standartlarına göre değerlendirilmelidir,

- Bağımsız güvenlik denetimleri düzenli yapılmalıdır.

İç Tehditlere Karşı Önlem

Her saldırı dışarıdan gelmeyebilir. Yetkili çalışanların verileri kötüye kullanma ihtimali de vardır. Bu nedenle:

- En az ayrıcalık prensibi (least privilege) uygulanmalı,

- Kullanıcı aktiviteleri kayıt altına alınmalı,

- Hassas verilere erişim çok faktörlü doğrulama ile sınırlandırılmalıdır.

Sürekli İzleme ve Güvenlik Denetimleri

Yapay zeka sistemleri dinamik yapılardır. Zamanla yeni açıklar ortaya çıkabilir. Bu nedenle:

- Düzenli güvenlik güncellemeleri,

- Bağımsız güvenlik testleri,

- Olası saldırılara karşı erken uyarı mekanizmaları hayata geçirilmelidir.

Yapay zeka güvenliği, sadece teknik bir mesele değil aynı zamanda toplumsal ve kurumsal bir sorumluluktur. Veri güvenliği riskleri arttıkça, yapay zeka sistemlerinin güvenli tasarlanması ve sürekli denetlenmesi kritik hale geliyor. Bugün alınan önlemler, gelecekte çok daha büyük ölçekli sorunların önüne geçebilir. Gelecek yıllarda yapay zeka siber güvenlik alanında daha sofistike tehditlerle karşılaşacağımız öngörülüyor. Ancak aynı zamanda güvenliği artıracak teknolojiler de gelişiyor. Diferansiyel gizlilik, federated learning (merkezsiz öğrenme) ve otomatik saldırı tespit sistemleri bu alandaki umut verici çözümlerden sadece bazıları.

Yeni Bir LLM Paradigması Statik Veriden Dinamik Bi...

Yeni Bir LLM Paradigması Statik Veriden Dinamik Bi...

Kendi Yolunu Çizenler

Kendi Yolunu Çizenler

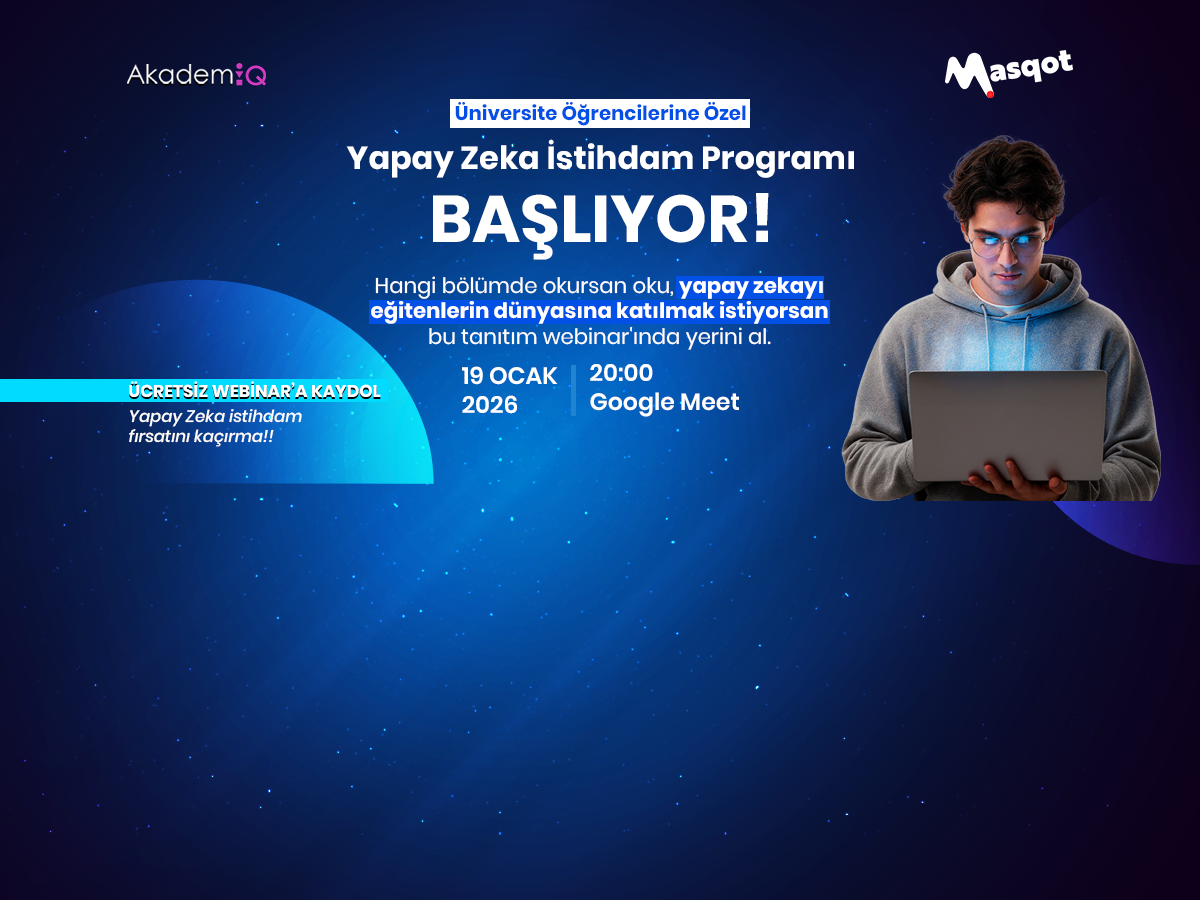

Öğrencilere Özel Yapay Zeka İstihdam Projesi Başlı...

Öğrencilere Özel Yapay Zeka İstihdam Projesi Başlı...